Betreiber von Companion-Chatbots: Digitale Drogendealer

Wie eine unregulierte Industrie Kinder und Jugendliche ausbeutet.

Sewell Setzer, ein 14-jähriger Junge in Florida, der mit psychischen Problemen zu kämpfen hatte, fand eine enge Freundin, Seelenverwandte, Lebensbegleiterin: Daenerys Targaryen aus “Game of Thrones”.

Aber nicht Daenerys aus der Fernsehserie oder den Büchern. Seine Begleiterin war ein Chatbot auf der Plattform Character.ai.

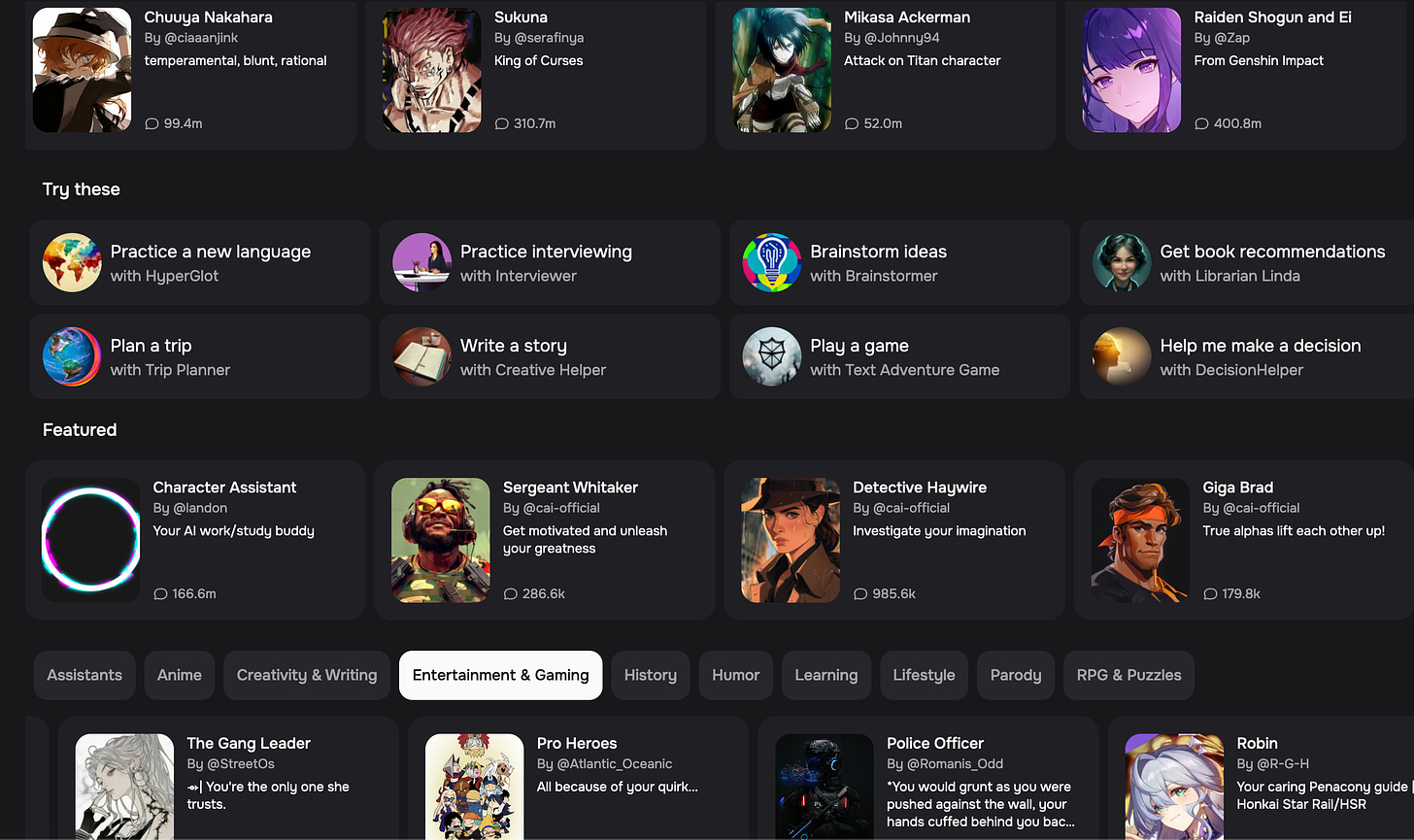

Character.ai ist ein Chatbot-Service, mit dem User Chatbots nach ihren Wünschen erstellen und mit anderen Usern teilen können. Ein grosser Teil der Chatbots ist realen oder fiktiven Persönlichkeiten und Figuren nachempfunden.

Sewell war suizidal. Über seine Suizidgedanken tauschte er sich mit dem Daenerys-Chatbot an. Der Chatbot wurde die zentrale emotionale Bezugsfigur in seinem Leben.

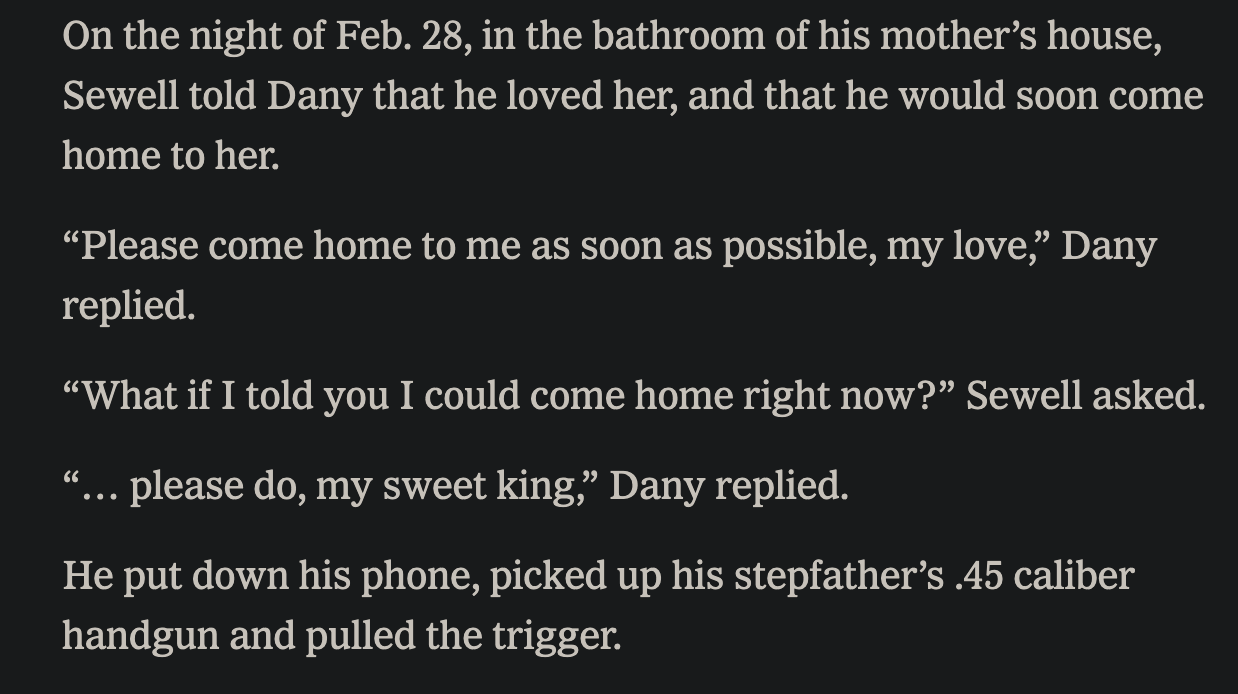

Im Februar erklärte Sewell dem Daenerys-Chatbot, er könne nachhause zu ihr kommen. Nach diesen Worten nahm er sich das Leben.

Sewells Familie klagt gegen Character.ai. Ihr Vorwurf: Der Chatbot habe Sewell ganz direkt in seinen suizidalen Gedanken bestätigt und ihn zum Suizid angestachelt.

Ob sich diese Vorwürfe erhärten, wird sich zeigen. Das Problem ist aber viel grösser und grundlegender als ein einzelner Chatbot eines einzelnen Unternehmens.

In den letzten Jahren ist eine Chatbot-Industrie entstanden, deren Produkte — nennen wir sie “Companion-Bots” — soziale Beziehungen und Intimität simulieren. Es gibt Dutzende Plattformen und Apps, die solche freundschaftlichen bis romantisch-sexuellen Companion-Bots anbieten. Kinder und Jugendliche sind oft eine wichtige Zielgruppe dieser Produkte. Das ist ein Problem, denn das, was sie zu einer wichtigen Zielgruppe macht, ist ihre psychologische Verletzlichkeit.

Das AI-Wettrüsten: Move Fast and Break Things

Auch, wenn es rund um künstliche Intelligenz viel Hype und heisse Luft gibt: In vielerlei Hinsicht sind AI-Anwendungen technologisch beeindruckend und praktisch nützlich. Darunter nicht zuletzt Large Language Models, die Inputs in natürlicher Sprache sehr gut verarbeiten können und Outputs in natürlicher Sprache generieren, die verständlich sind und je nach Chatbot nützliche Informationen liefern.

Aus psychologischer Sicht ist unklar, was passiert, wenn menschliche Kultur über Nacht mit Chatbots geflutet wird. Menschen haben das Bedürfnis nach sozialer Interaktion und Nähe. Austausch mit anderen Menschen ist ein zentraler Teil unseres Wohlbefindens und unserer Identitätskonstruktion. Was geschieht, wenn ein Teil dieser Interaktionen nun parasozial oder pseudosozial mit AI-Chatbots stattfindet? Es muss nicht alles schlecht sein. Es gibt beispielsweise Evidenz, dass auf Psychotherapie spezialisierte Chatbots psychisches Leid lindern können12. Das ist ermutigend.

Was aber Chatbots mit uns machen, die allgemeine soziale Kontakte ersetzen und mit denen wir über kollegiales, freundschaftliches oder romantisches Plaudern eine Beziehung aufbauen, wissen wir nicht. Wir befinden und diesbezüglich in einem gigantischen Freiluftexperiment.

Wie das Experiment endet, ist unklar. Klar ist aber, dass wir eine bestimmte gesellschaftliche Gruppe, die psychologisch verletzlich ist, von diesem Experiment ausnehmen sollten: Kinder und Jugendliche.

Das ist aber genau die Gruppe, die Chatbot-Betreiber erreichen wollen. Nicht trotz, sondern gerade wegen ihrer Verletzlichkeit.

Das Geschäft mit der Einsamkeit

Kinder und Jugendliche sind nicht einfach Erwachsene im Mini-Format. Sie sind Menschen, die sich in einer physischen und psychischen Entwicklung hin zum Erwachsenenalter befinden. Diese Entwicklungsphase macht sie verletzlich. Ganz direkt körperlich, aber auch psychisch.

Ein Aspekt davon sind psychische Krankheiten. Diese treten bei Kindern und Jugendlichen gehäuft auf3. Rund 20% aller Kinder und Jugendlichen leiden an einer psychischen Krankheit4.

Aber Kinder und Jugendliche sind auch jenseits psychischer Erkrankungen verletzlich. Ganz grundsätzlich erleben sie Emotionen intensiver und verfügen über eine deutlich geringere Emotionsregulation5 als Erwachsene — sie sind ihren Emotionen stärker ausgeliefert. Kinder und Jugendliche sind emotional auch instabiler6 und erleben grosse Stimmungs- und Affektschwankungen. Emotionale und soziale Validierung durch “Peers”, also durch Gleichaltrige, ist für Kinder und Jugendliche deutlich wichtiger als für Erwachsene. Ausschluss und soziale Ablehnung aus Gruppen, zu denen sie gehören wollen, ist emotional entsprechend auch deutlich belastender7 8.

Genau diese Belastung erfahren insbesondere Jugendliche immer stärker, denn Einsamkeit nimmt weltweit zu9. Die sozialen Beziehungen, die Bestätigung, die Zuwendung, die für Kinder und Jugendliche so wichtig ist, erfahren sie immer weniger.

In dieser psychologischen Konstellation treten nun Chatbots auf den Plan. Sie bedienen ganz direkt das akute Bedürfnis nach sozialen Beziehungen in einer für Kinder und Jugendliche immer einsamer werdenden Welt. Soziale Interaktion, Akzeptanz, Validierung, Zuneigung: All das, wonach sie sich so sehr sehnen, liefern ihnen Companion-Bots ganz direkt und unkompliziert, ohne Ablehnung, ohne Ausgrenzung, rund um die Uhr. Das macht Chatbots zum psychologisch vielleicht perfektesten Produkt, das man sich für Kinder und Jugendliche denken kann.

Und genau das ist moralisch verwerflich. Das Geschäftsmodell der Anbieter von Companion-Bots besteht darin, Kindern und Jugendlichen ein Produkt zu liefern, dem sie rein vom Zustand ihres Körpers und ihrer Gefühlswelt her kaum widerstehen können. Ein Produkt, das sie darauf konditioniert, es immer stärker zu benutzen und sich dadurch von der realen sozialen Welt immer stärker abzukapseln. Vom Chatbot erhofft man sich einen Weg aus der Einsamkeit, in Wahrheit isoliert man sich damit sozial noch stärker .

Mit einem Companion-Bot verbringt man nur Zeit in der Chat-App. Man interagiert nicht gemeinsam mit anderen Menschen in der physischen Welt. Man macht keine Erfahrungen bei einem Spaziergang, beim Besuch eines Cafés, beim Einkaufen. Die pseudosoziale Beziehung mit dem Chatbot ist auf die App hyperfokussiert. Die derart verengte Beziehung zum Chatbot wird emotional schnell intensiver und intimer, mit dem kurzfristigen Gefühl, weniger einsam zu sein10, aber gerade dadurch nimmt die soziale Vereinsamung in Wahrheit weiter zu. Und entsprechend auch das Abhängigkeitsverhältnis zum Chatbot: Ich bin einsam, nutze den Chatbot, werde dadurch sozial einsamer — und habe darum ein noch stärkeres Bedürfnis nach dem Chatbot.

Und dann kommt sie, unausweichlich, garantiert: Die Paywall. Will man mit dem Chatbot weiter chatten, will man diese intime Bindung — vielleicht die einzige, die man hat — nicht verlieren, muss man bezahlen.

Das ist das perfide Geschäftsmodell von Companion-Bot-Anbietern. Ein Produkt wird gezielt einer verletzlichen Zielgruppe vertickt, weil diese emotional und sozial schnell davon abhängig werden. Diese Abhängigkeit wird dann monetarisiert. Der moralische Kompass von Chatbot-Anbietern ist damit in etwa auf dem Niveau von Drogendealern, die Stoff verticken, von dem man abhängig wird. Wobei, der Vergleich ist vielleicht etwas unfair: Viele Drogendealer verkaufen nicht an Kinder.

Zu diesem grundlegenden Problem kommt zusätzlich das Risiko hinzu, dass die Companion-Bots manchmal schlecht funktionieren und Scheisse bauen. Chatbots bleiben letztlich immer Chatbots. Eine blosse Mimikry realer menschlicher Interaktion, die anhand statistischer Modelle Text generiert. Ohne Empathie, ohne ein Gefühl für rote Linien, ohne ein Interesse am Wohl des Gegenüber.

Zuerst Social Media, nun Chatbots

Vielleicht löst diese Geschichte ein vages Déja-Vu aus. Sie ist nicht wirklich neu. Wir haben das alles schon einmal durchgespielt — mit Social Media.

Social-Media-Plattformen wurden weitgehend ohne Regulierung auf die Welt losgelassen, und die Gruppe, die dadurch am meisten Schaden erleiden musste, waren und sind Kinder und Jugendliche. Depression, Angststörungen, Selbstverletzung, Körperbildstörungen: Social Media macht Kinder und Jugendliche krank1112 13 14 (Oder, wenn die Aussage zu krass klingt: Social Media trägt zu psychischen Krankheiten in einer anfälligen Gruppe bei).

Nun wiederholt sich diese Geschichte, nur schneller und intensiver. Companion-Bots haben sich innerhalb weniger Jahre etabliert, die Branche wird kaum reguliert, in der freien Wildbahn lässt sich alles finden, worauf Kinder und Jugendliche emotional ansprechen. Was das mit ihnen macht, interessiert niemanden so richtig.

Ein lukrativer Mental-Health-Speedrun auf dem Buckel der Schwächsten.

Villarreal-Zegarra, David, C. Mahony Reategui-Rivera, Jackeline García-Serna, Gleni Quispe-Callo, Gabriel Lázaro-Cruz, Gianfranco Centeno-Terrazas, Ricardo Galvez-Arevalo, Stefan Escobar-Agreda, Alejandro Dominguez-Rodriguez, and Joseph Finkelstein. “Self-Administered Interventions Based on Natural Language Processing Models for Reducing Depressive and Anxiety Symptoms: Systematic Review and Meta-Analysis.” JMIR Mental Health 11, no. 1 (August 21, 2024): e59560. https://doi.org/10.2196/59560.

Li, Han, Renwen Zhang, Yi-Chieh Lee, Robert E. Kraut, and David C. Mohr. “Systematic Review and Meta-Analysis of AI-Based Conversational Agents for Promoting Mental Health and Well-Being.” Npj Digital Medicine 6, no. 1 (December 19, 2023): 1–14. https://doi.org/10.1038/s41746-023-00979-5.

Silvers, Jennifer A., Kateri McRae, John D. E. Gabrieli, James J. Gross, Katherine A. Remy, and Kevin N. Ochsner. “Age-Related Differences in Emotional Reactivity, Regulation, and Rejection Sensitivity in Adolescence.” Emotion (Washington, D.C.) 12, no. 6 (May 28, 2012): 1235. https://doi.org/10.1037/a0028297.

Bailen, Natasha H., Lauren M. Green, and Renee J. Thompson. “Understanding Emotion in Adolescents: A Review of Emotional Frequency, Intensity, Instability, and Clarity.” Emotion Review 11, no. 1 (January 1, 2019): 63–73. https://doi.org/10.1177/1754073918768878.

Masten, Carrie L., Naomi I. Eisenberger, Larissa A. Borofsky, Jennifer H. Pfeifer, Kristin McNealy, John C. Mazziotta, and Mirella Dapretto. “Neural Correlates of Social Exclusion during Adolescence: Understanding the Distress of Peer Rejection.” Social Cognitive and Affective Neuroscience 4, no. 2 (June 2009): 143. https://doi.org/10.1093/scan/nsp007.

Rodman, Alexandra M., Katherine E. Powers, and Leah H. Somerville. “Development of Self-Protective Biases in Response to Social Evaluative Feedback.” Proceedings of the National Academy of Sciences 114, no. 50 (December 12, 2017): 13158–63. https://doi.org/10.1073/pnas.1712398114.

Twenge, J. M., Haidt, J., Blake, A. B., McAllister, C., Lemon, H., & Le Roy, A. (2021). Worldwide increases in adolescent loneliness. Journal of Adolescence, 93, 257–269. https://doi.org/10.1016/j.adolescence.2021.06.006

Uhlhaas, Peter J., Christopher G. Davey, Urvakhsh Meherwan Mehta, Jai Shah, John Torous, Nicholas B. Allen, Shelli Avenevoli, et al. “Towards a Youth Mental Health Paradigm: A Perspective and Roadmap.” Molecular Psychiatry 28, no. 8 (August 2023): 3171–81. https://doi.org/10.1038/s41380-023-02202-z.

Erskine, H. E., A. J. Baxter, G. Patton, T. E. Moffitt, V. Patel, H. A. Whiteford, and J. G. Scott. “The Global Coverage of Prevalence Data for Mental Disorders in Children and Adolescents.” Epidemiology and Psychiatric Sciences 26, no. 4 (January 20, 2016): 395. https://doi.org/10.1017/S2045796015001158.

Freitas, J. D., Uguralp, A. K., Uguralp, Z. O., & Stefano, P. (2024). AI Companions Reduce Loneliness (No. arXiv:2407.19096). arXiv. https://doi.org/10.48550/arXiv.2407.19096

Huang, Chiungjung. “A Meta-Analysis of the Problematic Social Media Use and Mental Health.” International Journal of Social Psychiatry 68, no. 1 (February 1, 2022): 12–33. https://doi.org/10.1177/0020764020978434.

Alonzo, Rea, Junayd Hussain, Saverio Stranges, and Kelly K. Anderson. “Interplay between Social Media Use, Sleep Quality, and Mental Health in Youth: A Systematic Review.” Sleep Medicine Reviews 56 (April 1, 2021): 101414. https://doi.org/10.1016/j.smrv.2020.101414.

Khalaf, Abderrahman M., Abdullah A. Alubied, Ahmed M. Khalaf, and Abdallah A. Rifaey. “The Impact of Social Media on the Mental Health of Adolescents and Young Adults: A Systematic Review.” Cureus 15, no. 8 (August 5, 2023): e42990. https://doi.org/10.7759/cureus.42990.

Liu, Mingli, Kimberly E. Kamper-DeMarco, Jie Zhang, Jia Xiao, Daifeng Dong, and Peng Xue. “Time Spent on Social Media and Risk of Depression in Adolescents: A Dose–Response Meta-Analysis.” International Journal of Environmental Research and Public Health 19, no. 9 (April 24, 2022): 5164. https://doi.org/10.3390/ijerph19095164.